Lab 2: Gobernando un modelo de IA predictiva

Prerrequisitos

- Antes de comenzar este laboratorio, debes haber completado los pasos 1 al 4 del Lab 1: Gobernando prompts de IA generativa, para tener configurados el AI use case, y el Project y Deployment space asociados.

- Comprueba que te encuentras en la plataforma Cloud Pak for Data.

En este laboratorio, continuarás con la tarea comenzada en el Lab 1: Gobernando prompts de IA generativa. Con el mismo caso de uso, etiquetado de tickets de soporte, probarás un nuevo enfoque con IA predictiva en lugar de generativa. Este modelo será gobernado de la misma manera, asociado al AI use case creado previamente.

1. Crea un Model

-

Además de Prompt Templates, la plataforma de watsonx.ai permite construir y desplegar Models, modelos de IA tradicional, con un comportamiento y capacidades similares a las del Prompt Template. Estos modelos pueden gobernarse en todo su ciclo de vida, para almacenar datos como las métricas de entrenamiento o el algoritmo empleado para construirlo.

Para este laboratorio, partiremos de un modelo ya entrenado, que alojarás en el Project creado previamente para trabajar desde ahí.

-

Abre el menú lateral en la esquina superior izquierda.

-

Haz click en el item Projects para desplegarlo.

-

Haz click en el item All projects.

-

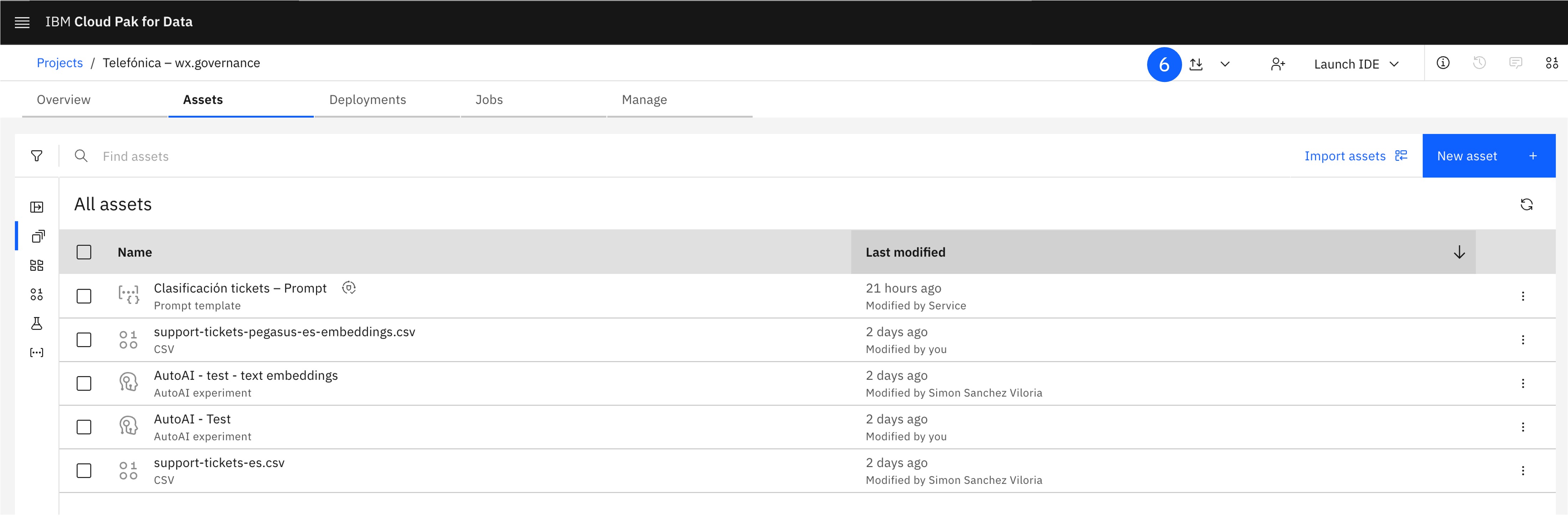

Abre el proyecto creado previamente.

-

En la parte superior, pulsa el botón de Export or import project.

-

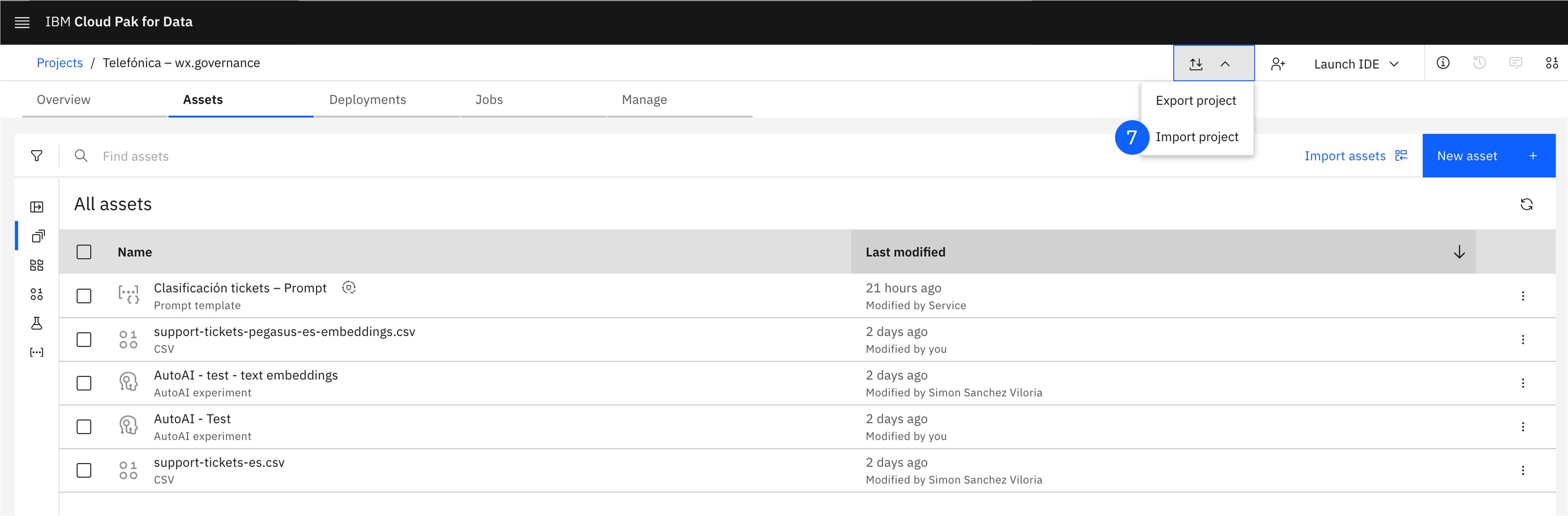

Haz click en Import project, lo que abrirá una nueva ventana.

-

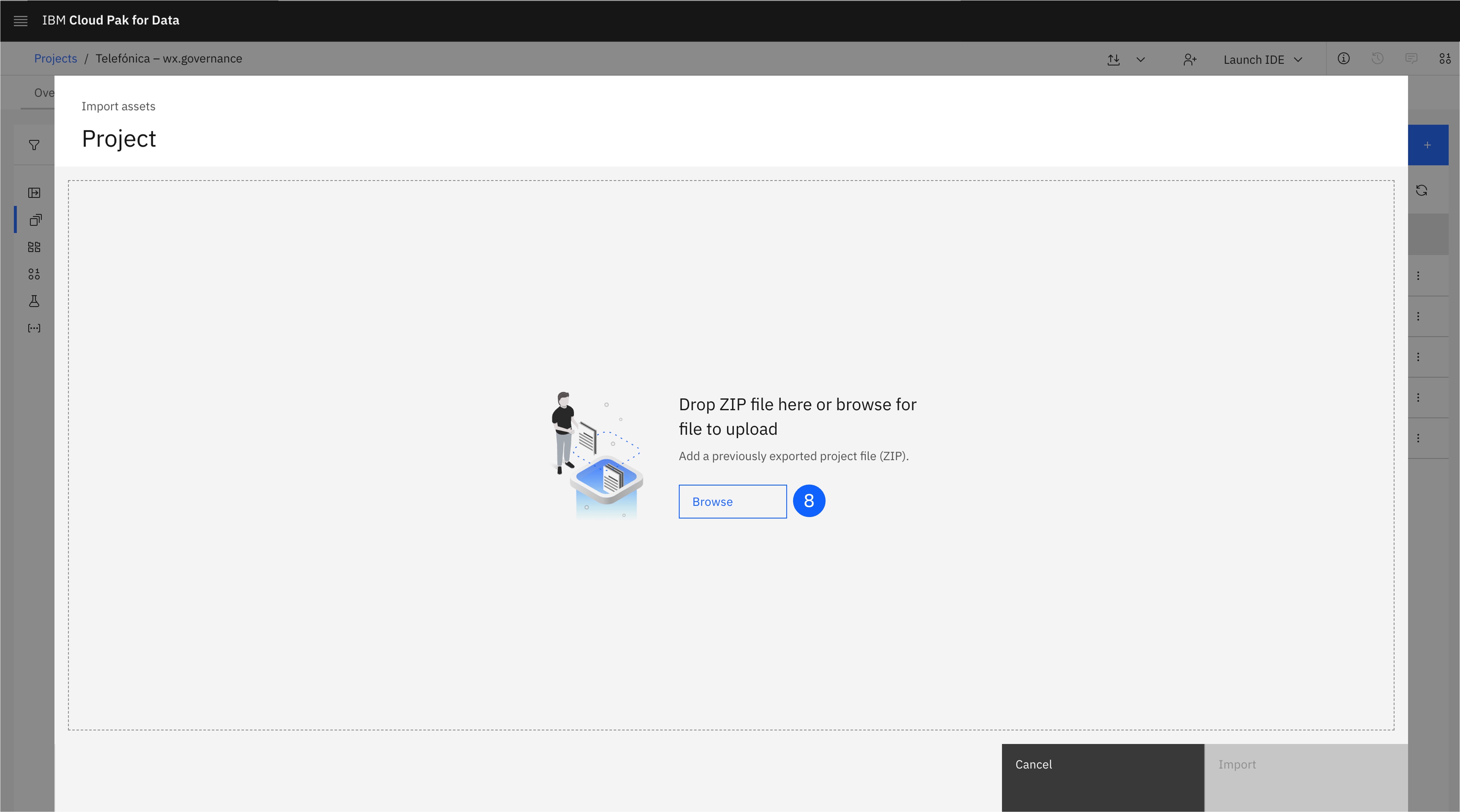

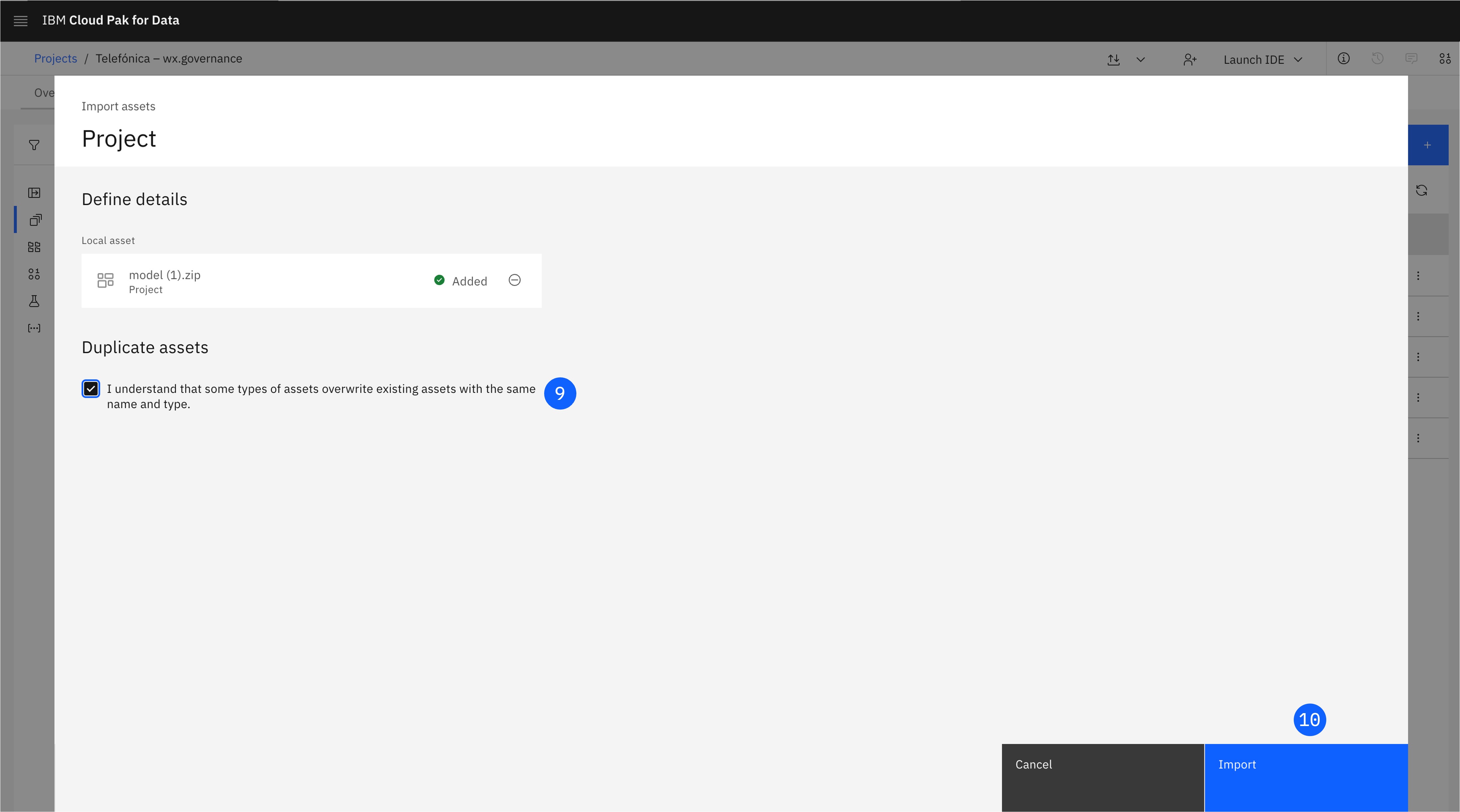

Arrastra la carpeta model.zip, que contiene un modelo de clasificación.

-

Marca la casilla en la que se indica que los activos contenidos en esta carpeta sobreescribirán los activos del mismo nombre en el Project de destino.

-

Pulsa Import.

-

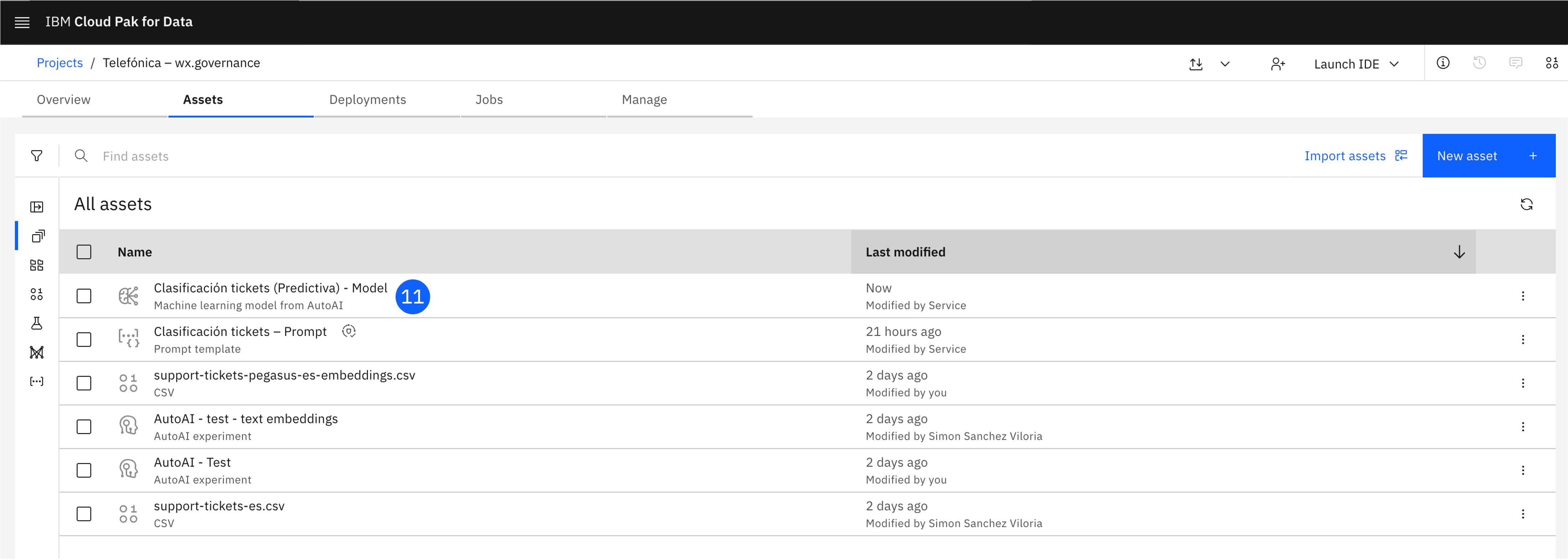

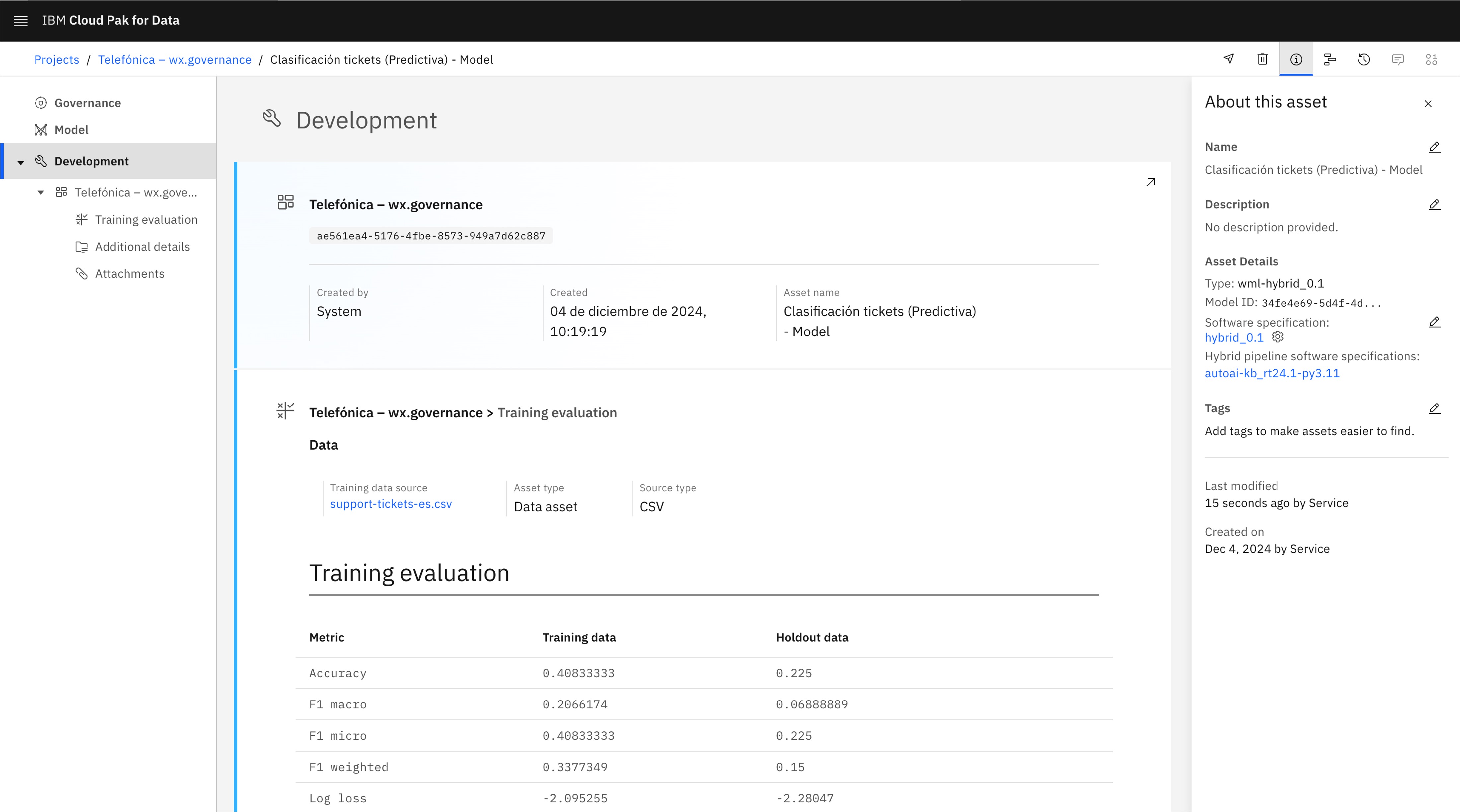

El Model ahora aparecerá como activo en el Project. Puedes explorar su AI Factsheet, que contiene las métricas de entrenamiento y otros datos.

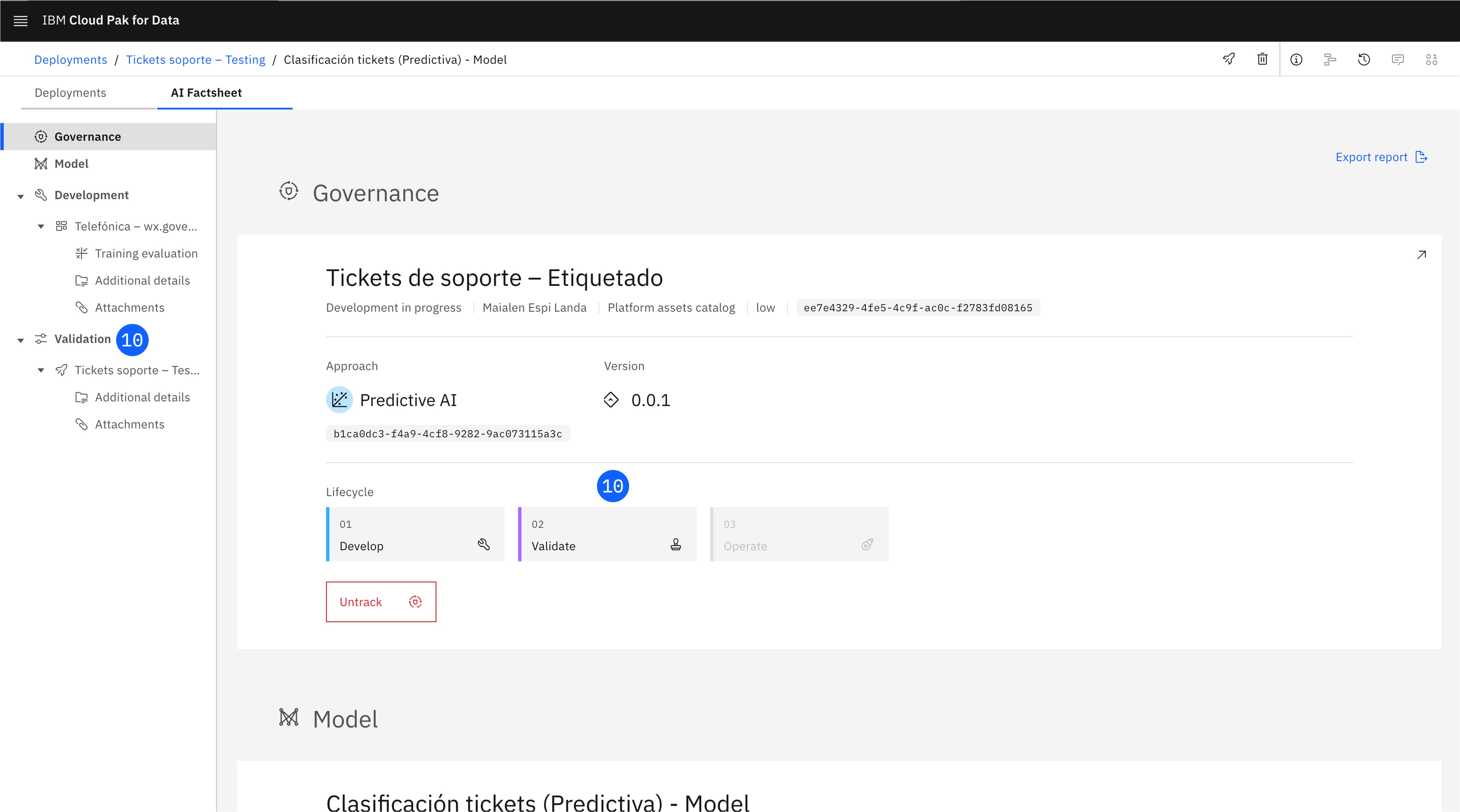

2. Trackea el Model

En este paso, se busca asociar el model al AI use case creado previamente, para realizar el seguimiento del modelo y poder visualizarlo en su ciclo de vida. Lo almacenaremos junto al prompt template en otro enfoque (approach).

-

En el Project, localiza el Model creado y haz click para abrirlo.

-

En la AI Factsheet del modelo, pulsa en Track in AI use case, lo que abrirá una nueva ventana.

-

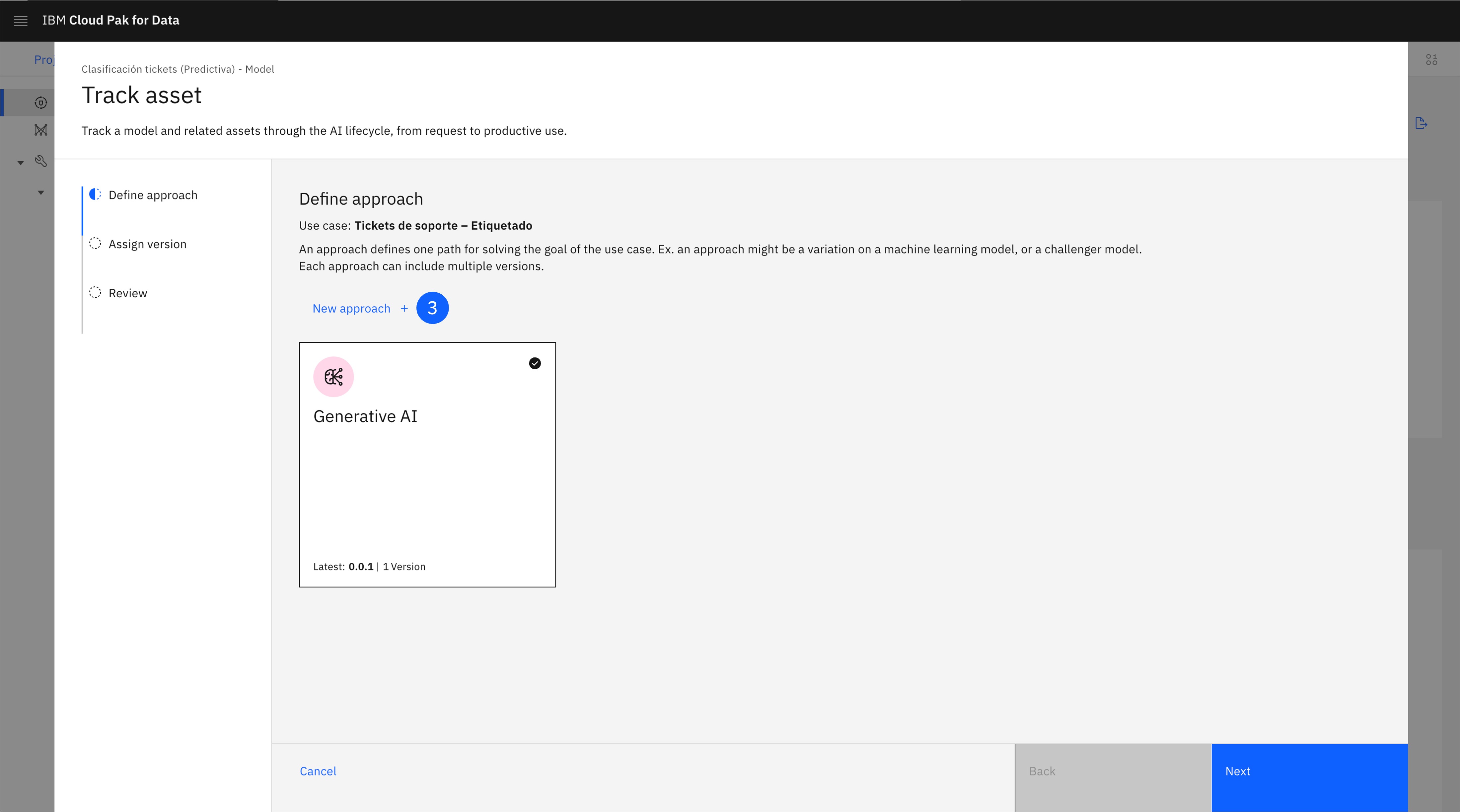

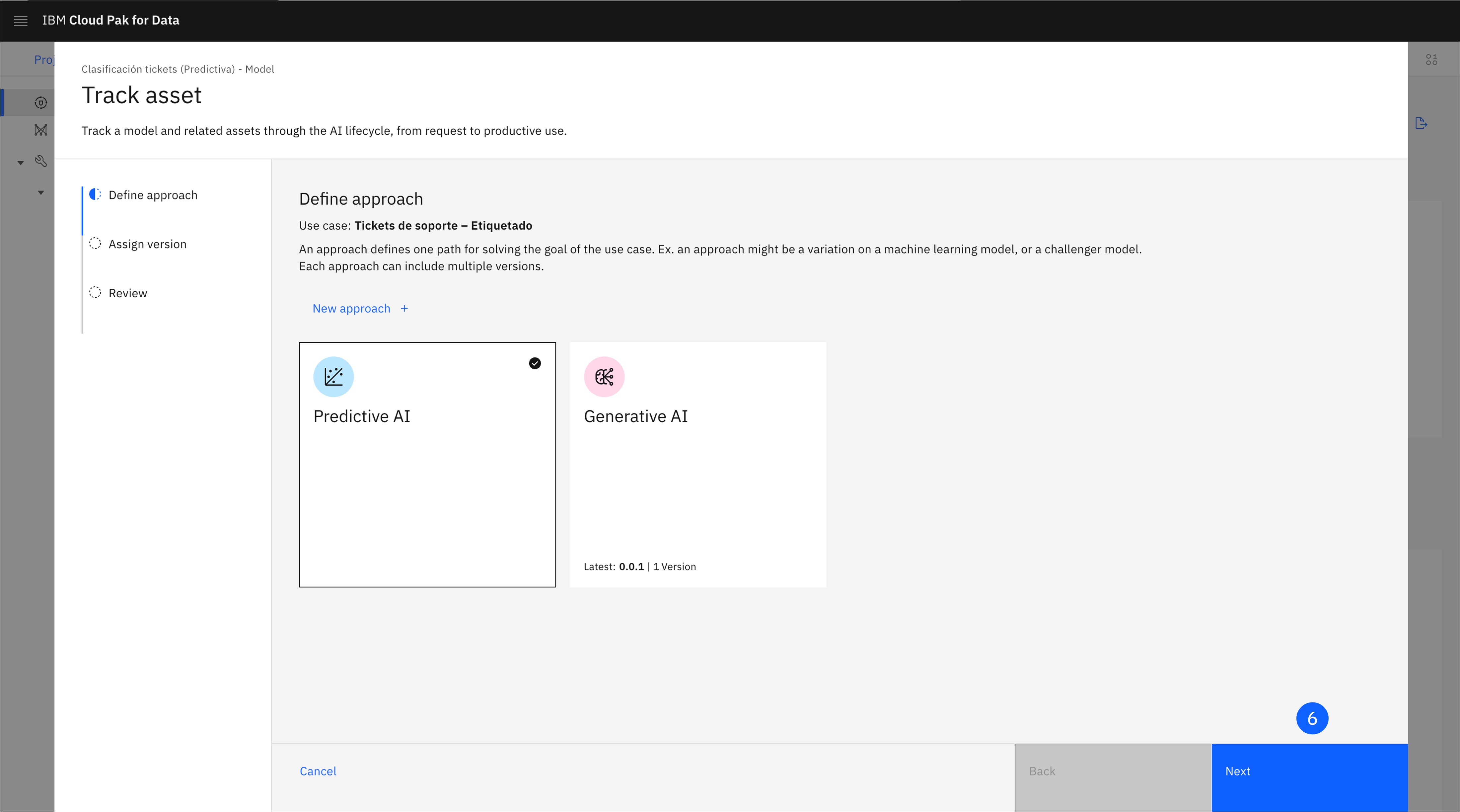

En la pantalla Define approach, deberás crear un nuevo enfoque para esta vía de uso de IA predictiva. Haz click en New approach.

-

Selecciona un Icon, Color, y Name que lo diferencie del approach de IA generativa.

-

Haz click en Create.

-

Selecciona el Approach recién creado y haz click en Next.

-

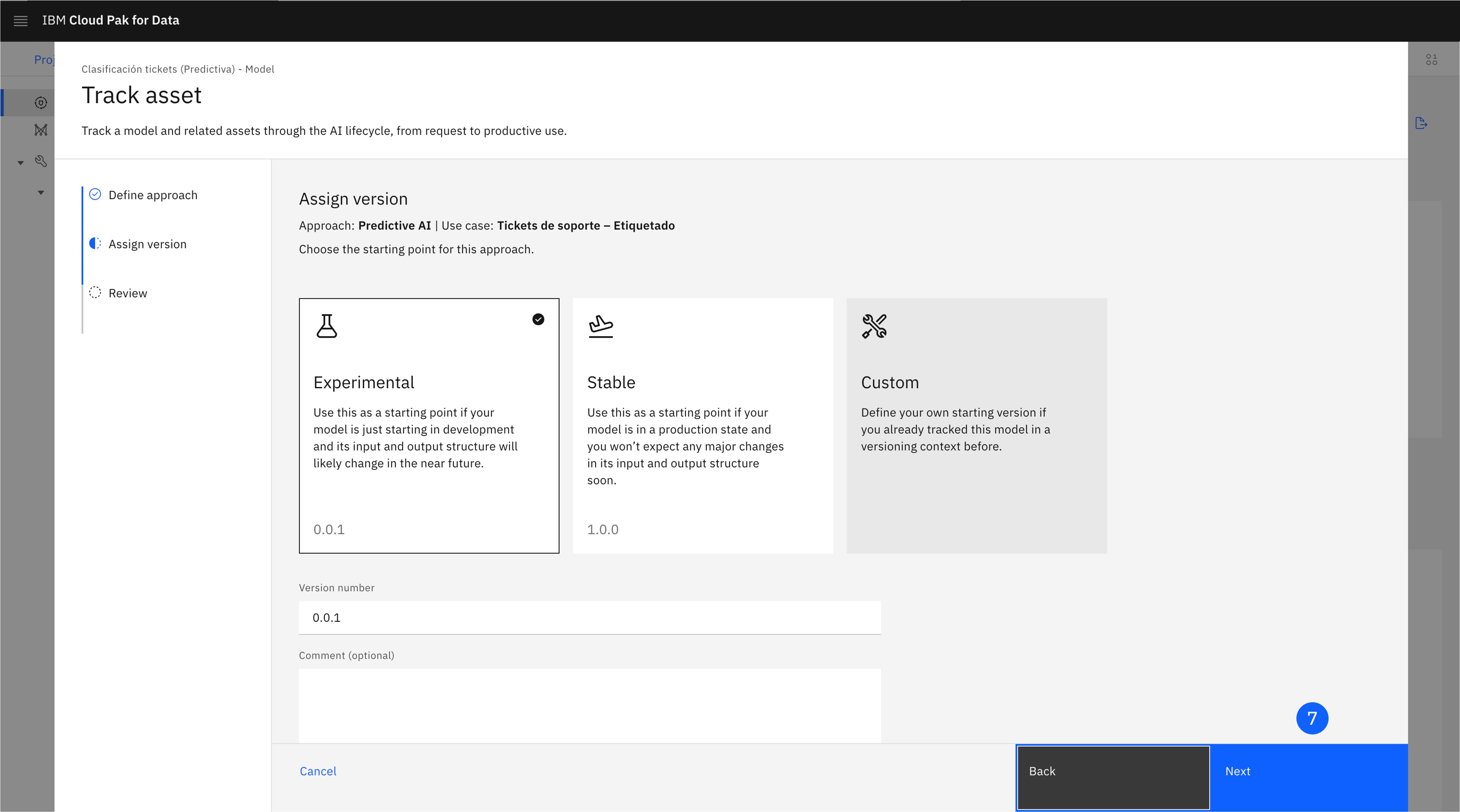

Deja seleccionada la opción Experimental. Ten en cuenta que aquí puedes asignar manualmente un número de versión, o elegir un número de versión más adecuado, según el estado del modelo. Haz clic en Next para avanzar a la pantalla de revisión (Review).

-

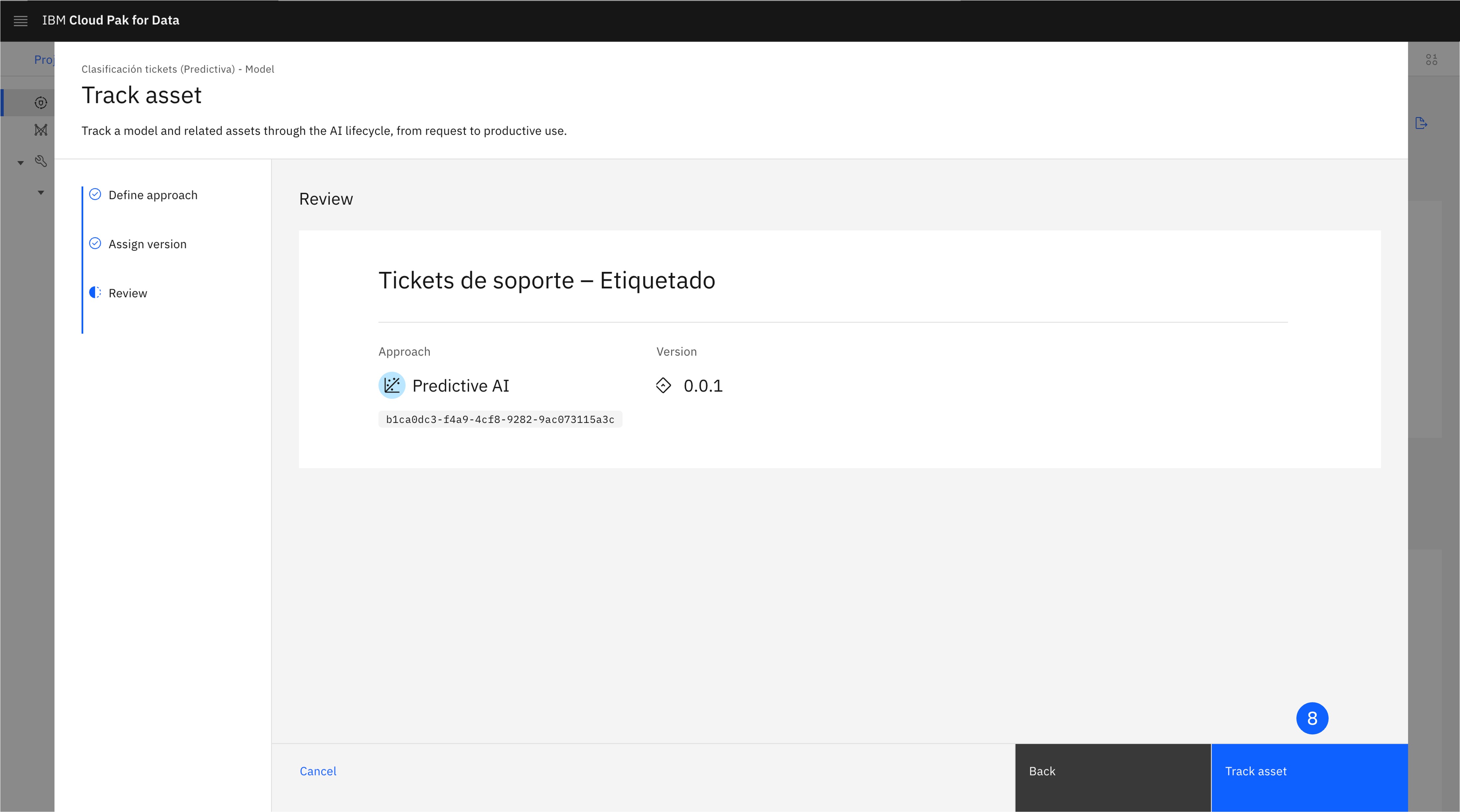

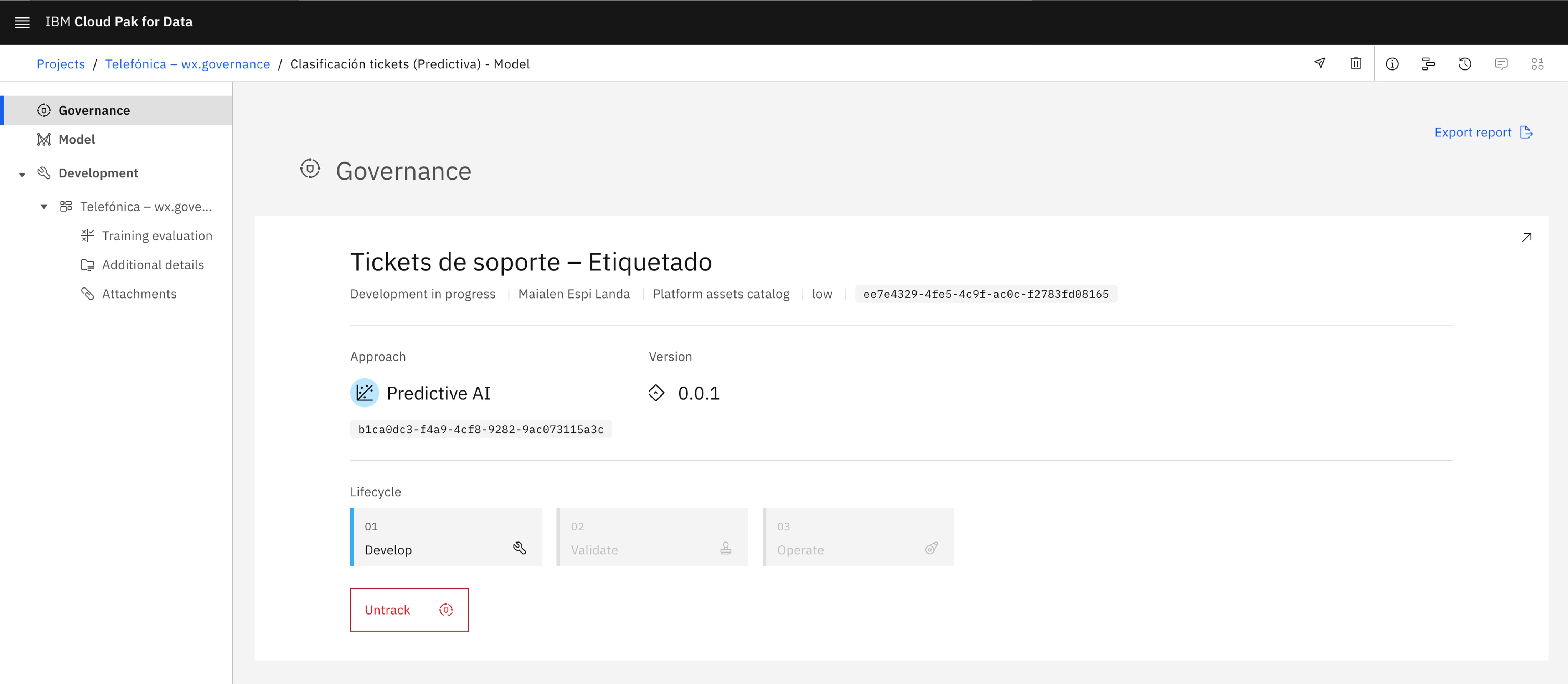

Haz clic en Track asset para comenzar a rastrear el modelo. La AI Factsheet se recargará e incluirá la información del caso de uso.

3. Despliega el Model

A continuación, promocionarás el model al espacio de despliegue y lo desplegarás.

-

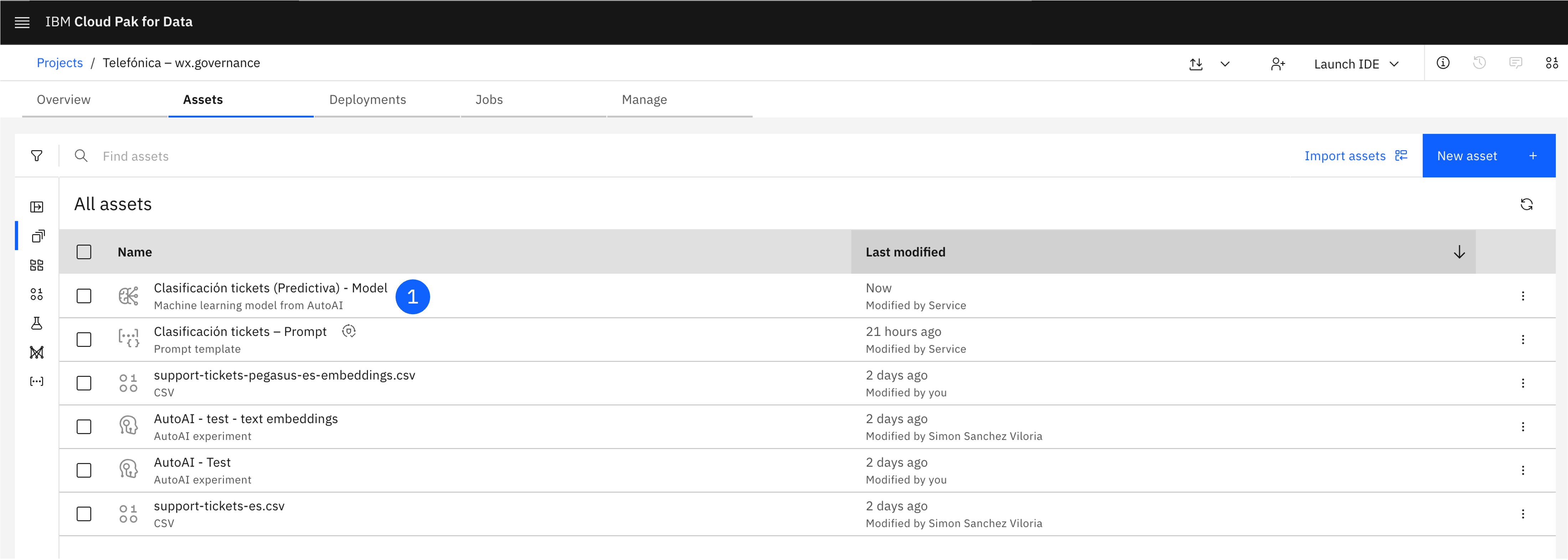

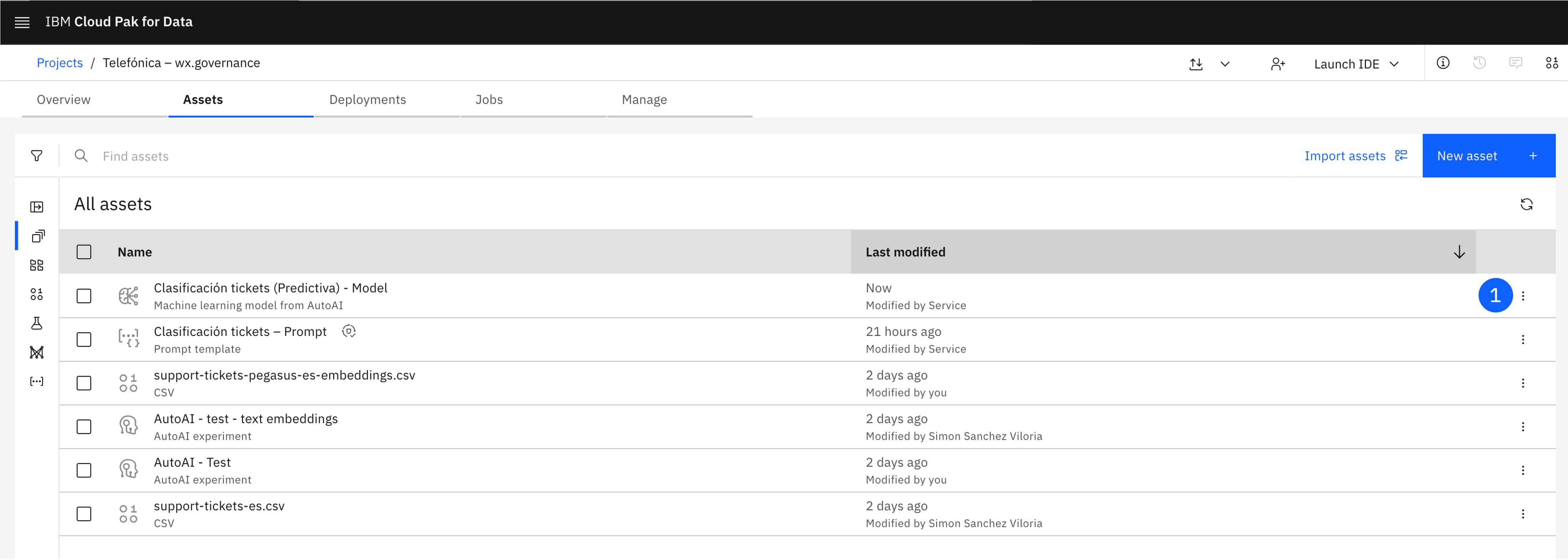

Localiza el Model creado, y pulsa en los tres puntos del lateral derecho para abrir el menú.

-

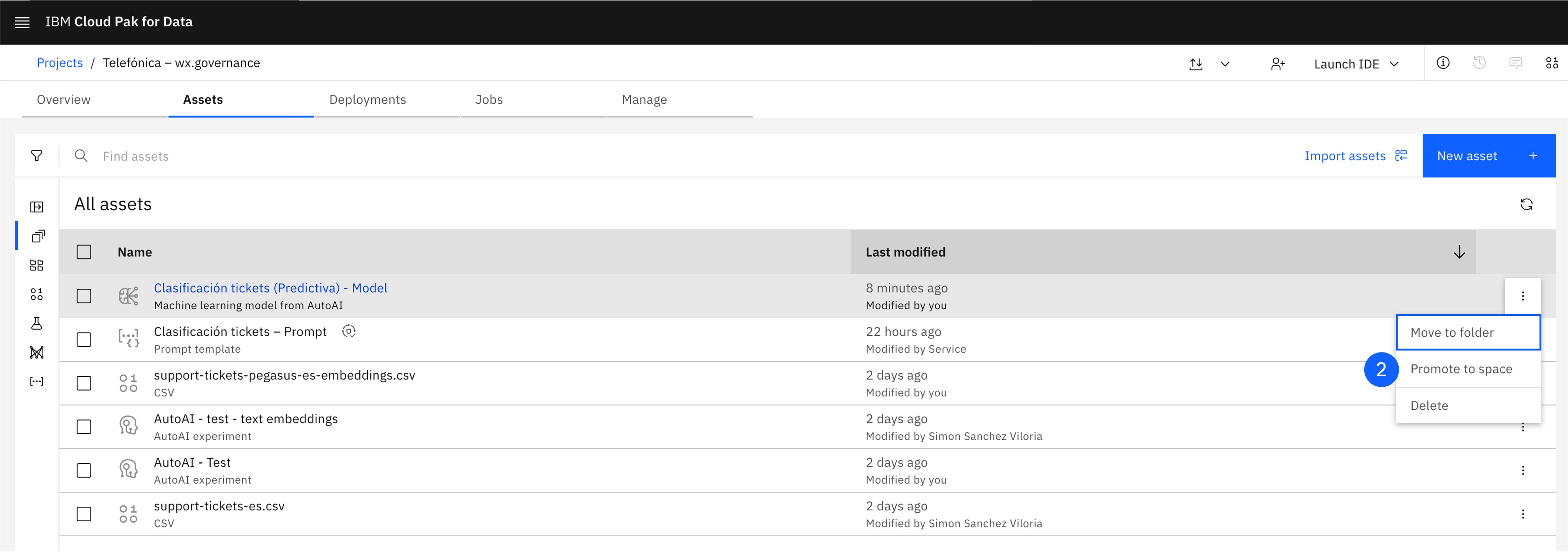

Pulsa en Promote to space, lo que abrirá una ventana.

-

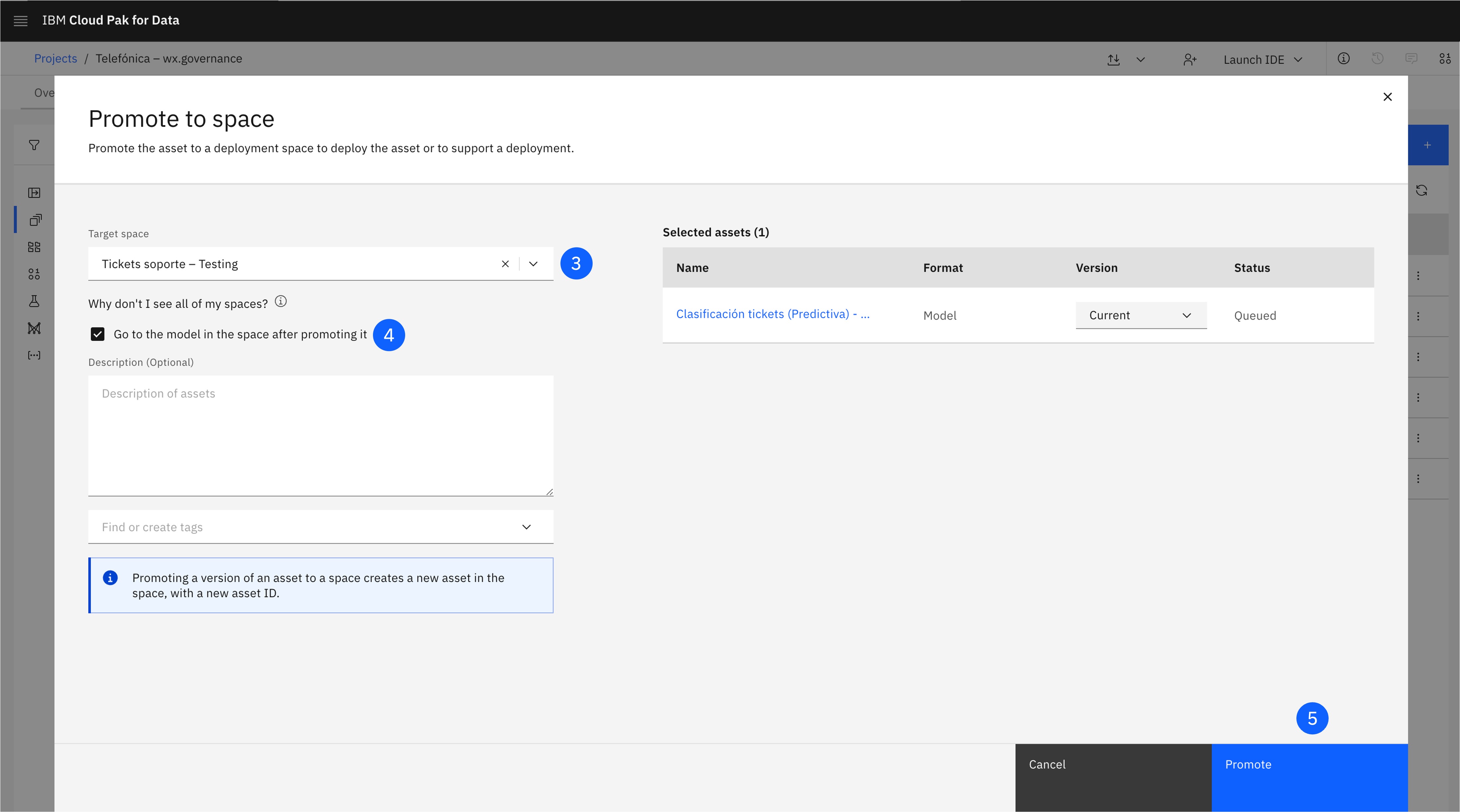

Selecciona el Deployment space creado previamente en Target space.

-

Selecciona la casilla Go to the space after promoting.

-

Haz click en Promote.

-

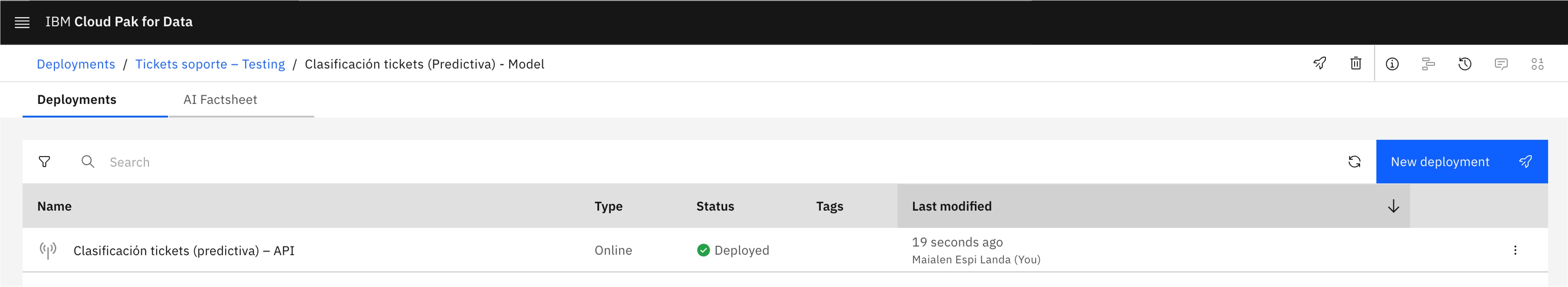

El model está promocionado al espacio de despliegue, pero todavía no está desplegado.

-

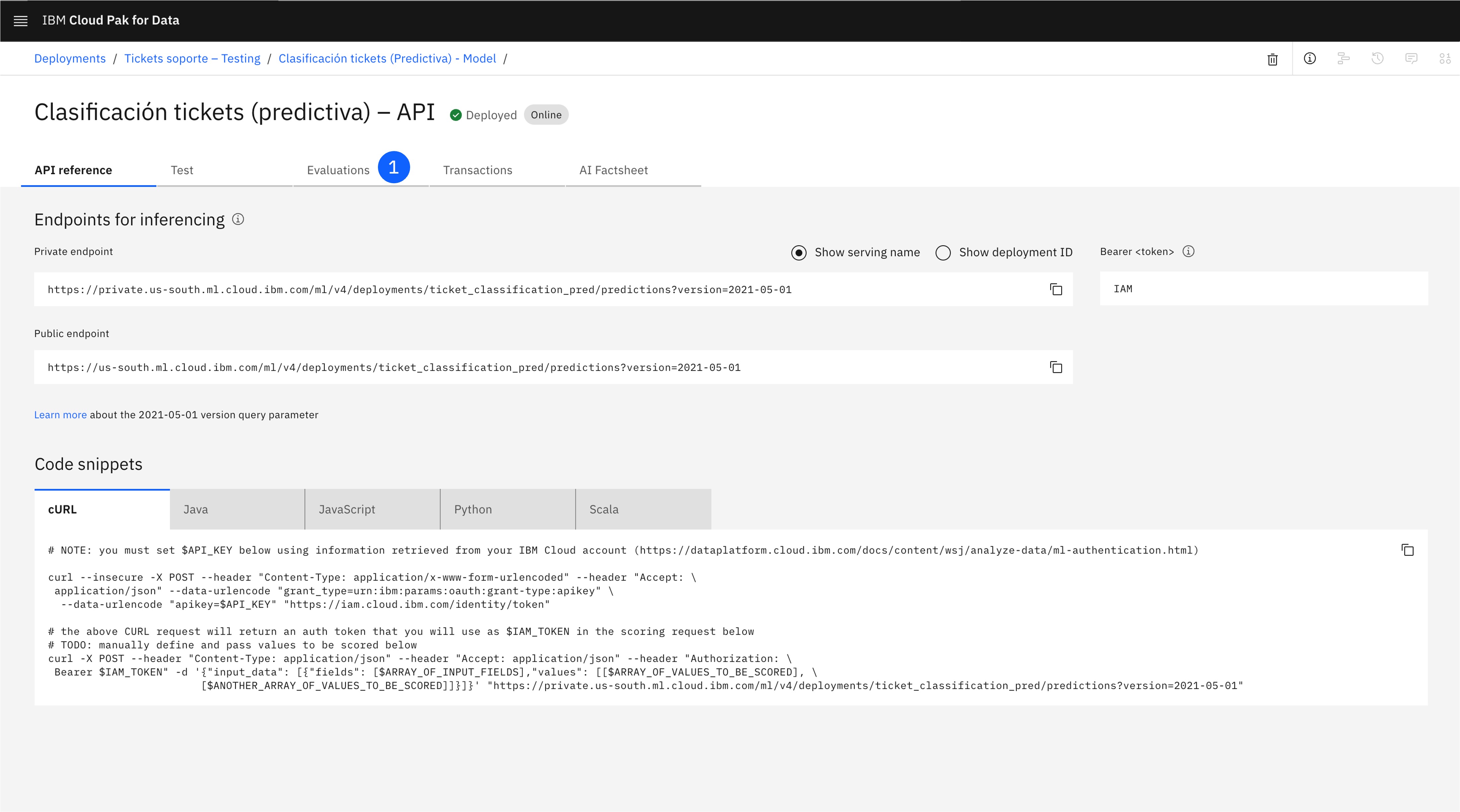

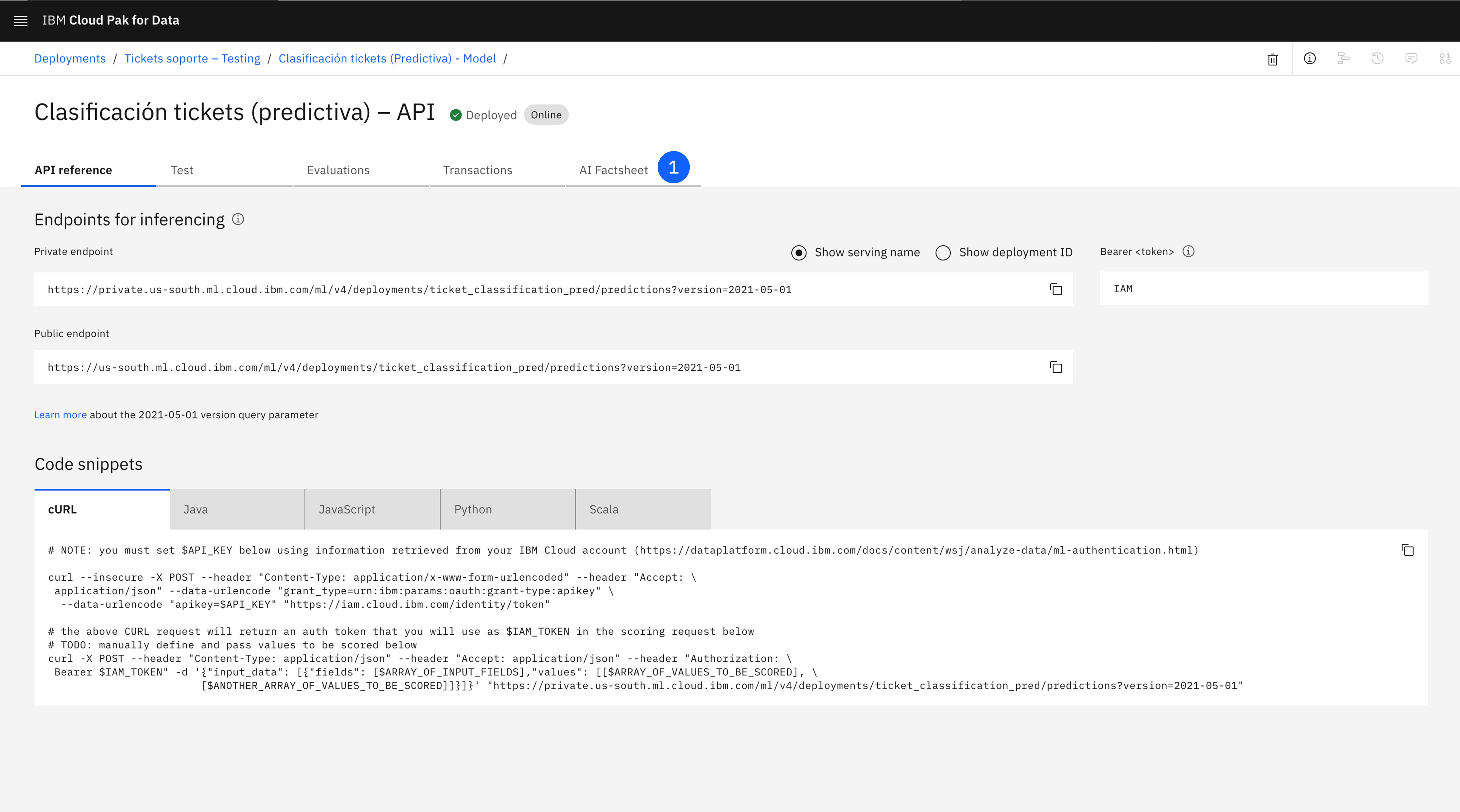

Para desplegarlo, pulsa en la esquina superior derecha en New deployment.

-

Asigna un Name y un Serving name.

-

Pulsa en Create. Espera a que se complete el despliegue, puede llevar unos momentos. Cuando el despliegue esté online, ya estará preparado para recibir peticiones vía API.

-

Revisa la AI Factsheet, que ahora contendrá también la información de despliegue en la etapa de Validation.

4. Evalúa el Model

Una vez desplegado el model, sólo queda evaluarlo con un conjunto de datos.

-

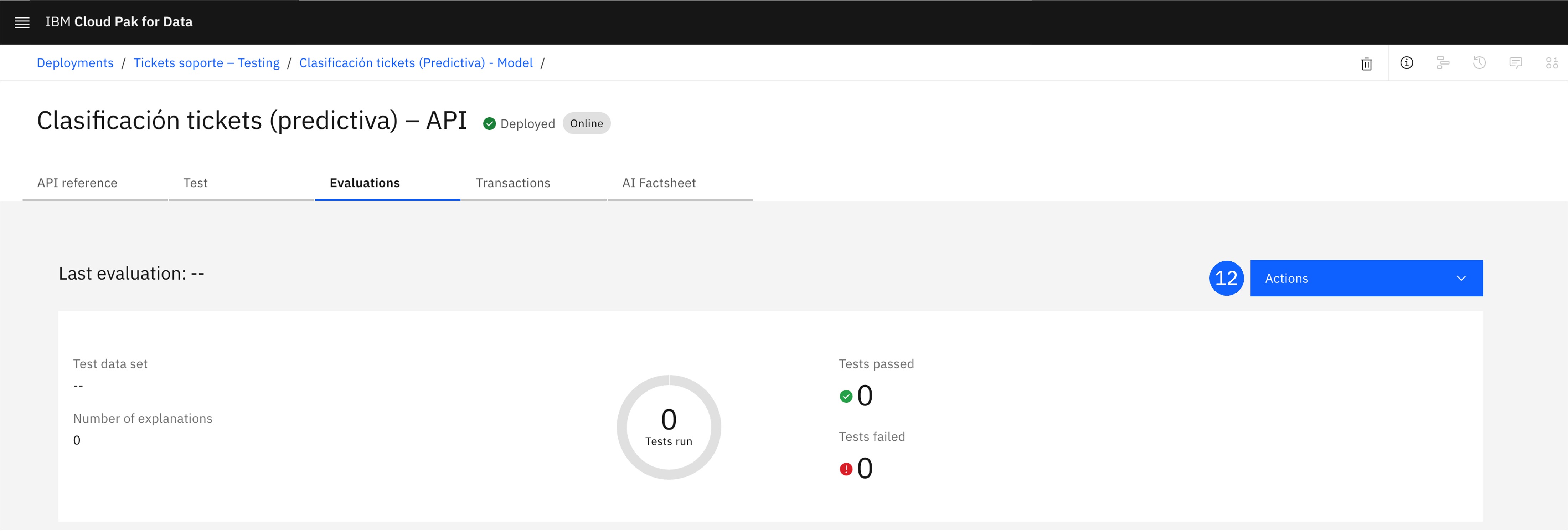

En la ventana del despliegue, abre la pestaña Evaluations.

-

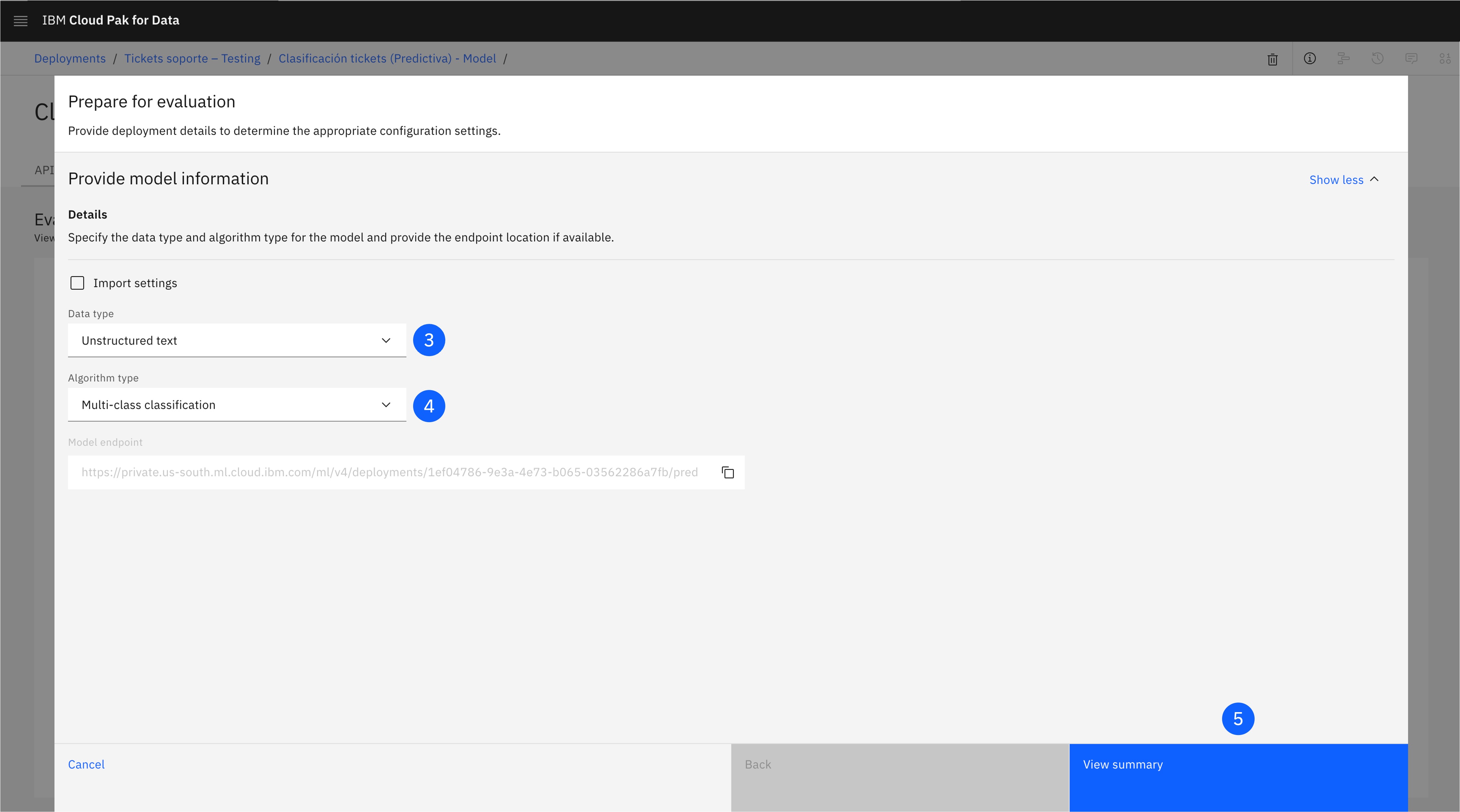

Pulsa Configure OpenScale evaluation settings, lo que abrirá una ventana.

-

En la pantalla Prepare for evaluation, deja marcado Sytem-managed y selecciona Unstructured text como Data type.

-

Como Algorithm type, selecciona Multi-class classification.

-

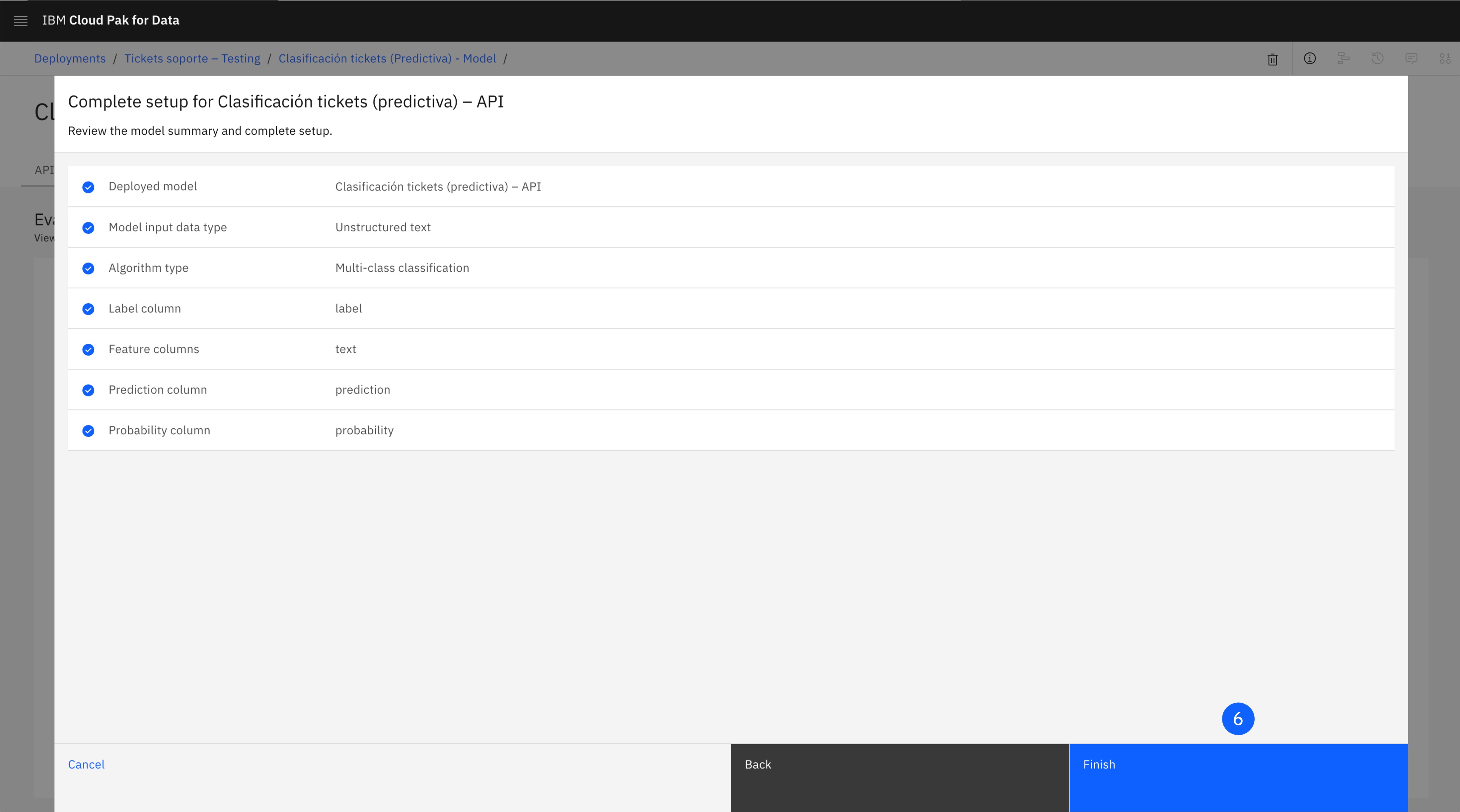

Haz click en View summary.

-

Haz click en Finish.

-

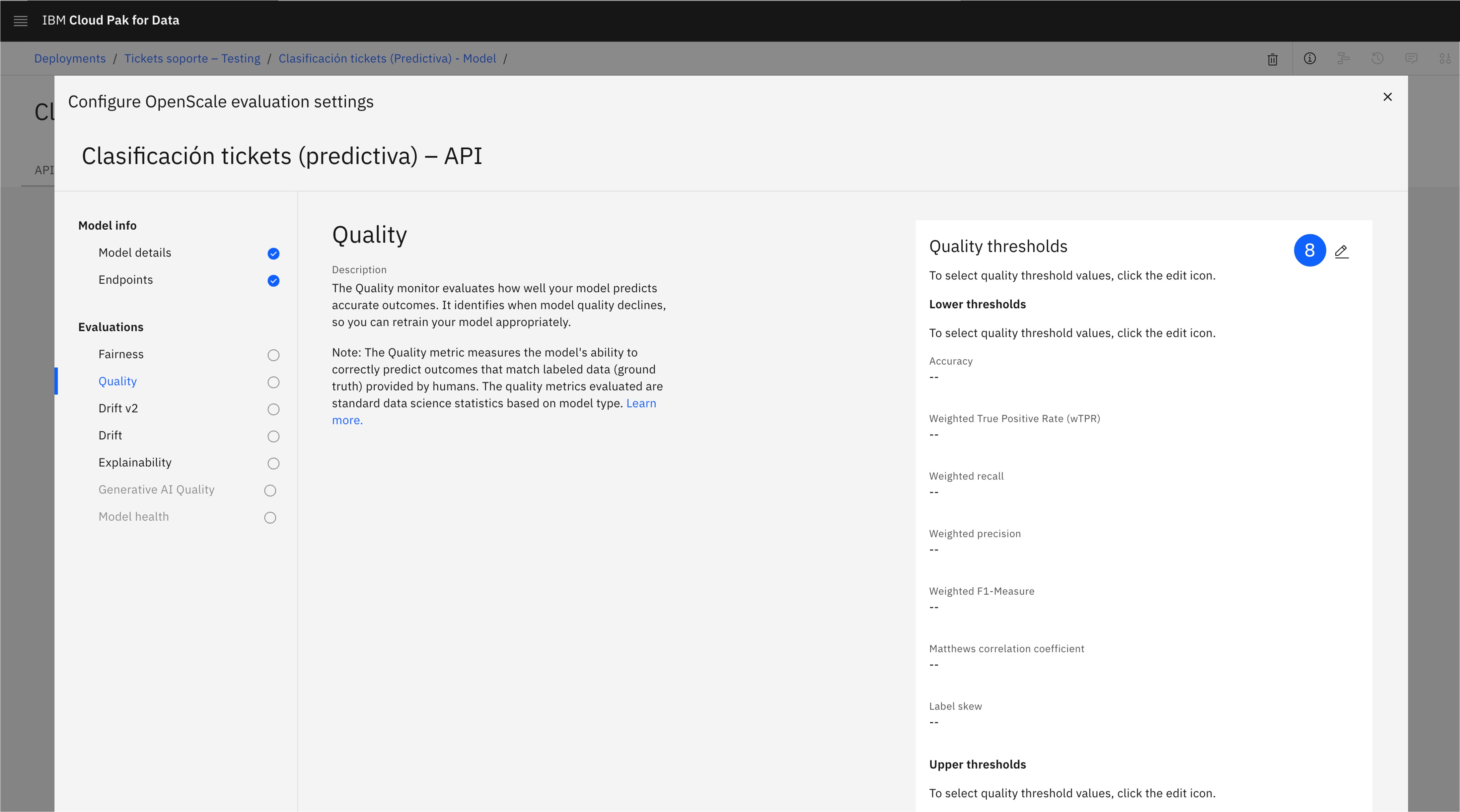

En la pantalla Configure OpenScale evaluation settings, abre la configuración de la métrica Quality.

-

Haz click en el botón de edición.

-

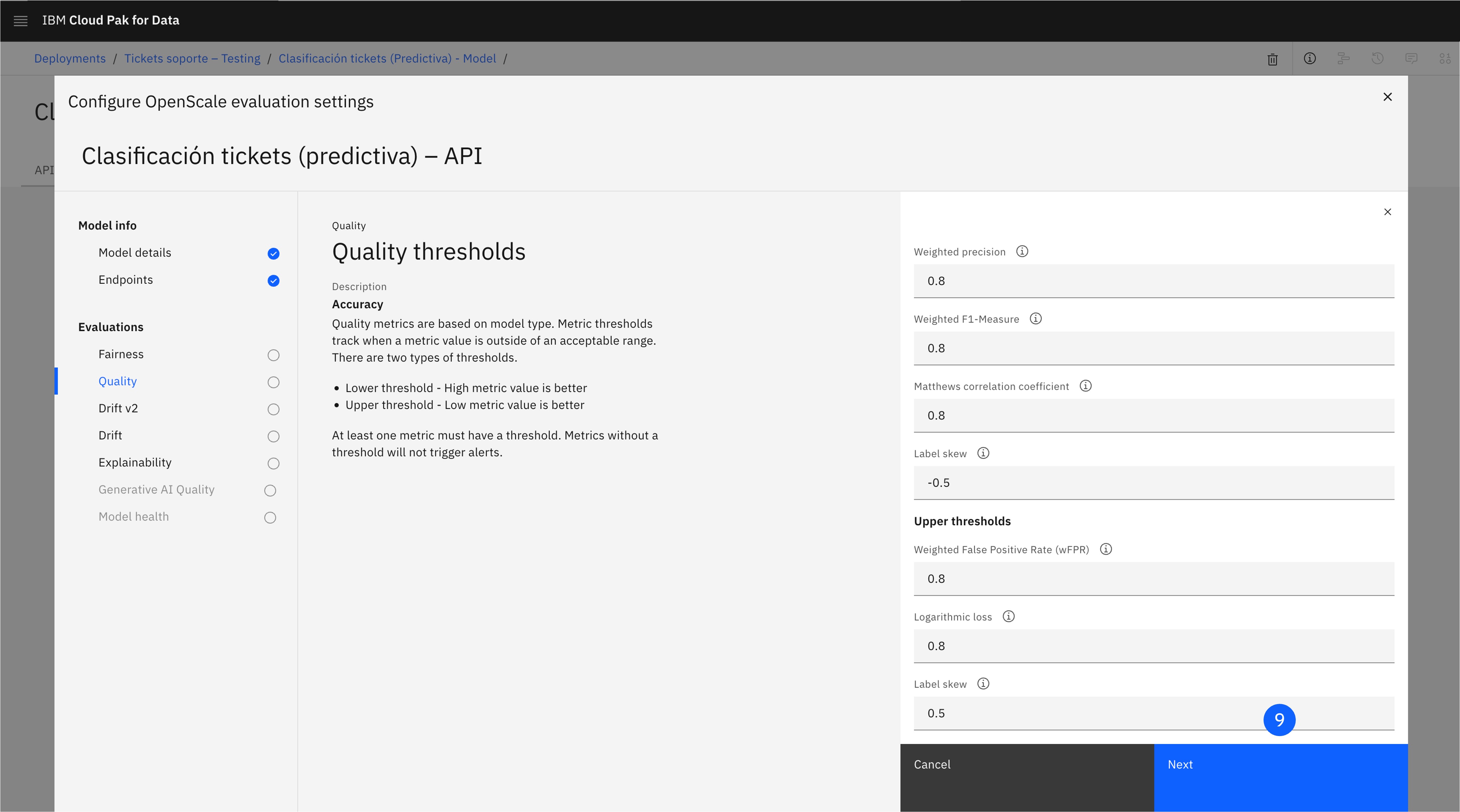

Acepta los valores predeterminados para los umbrales, pulsando Next.

-

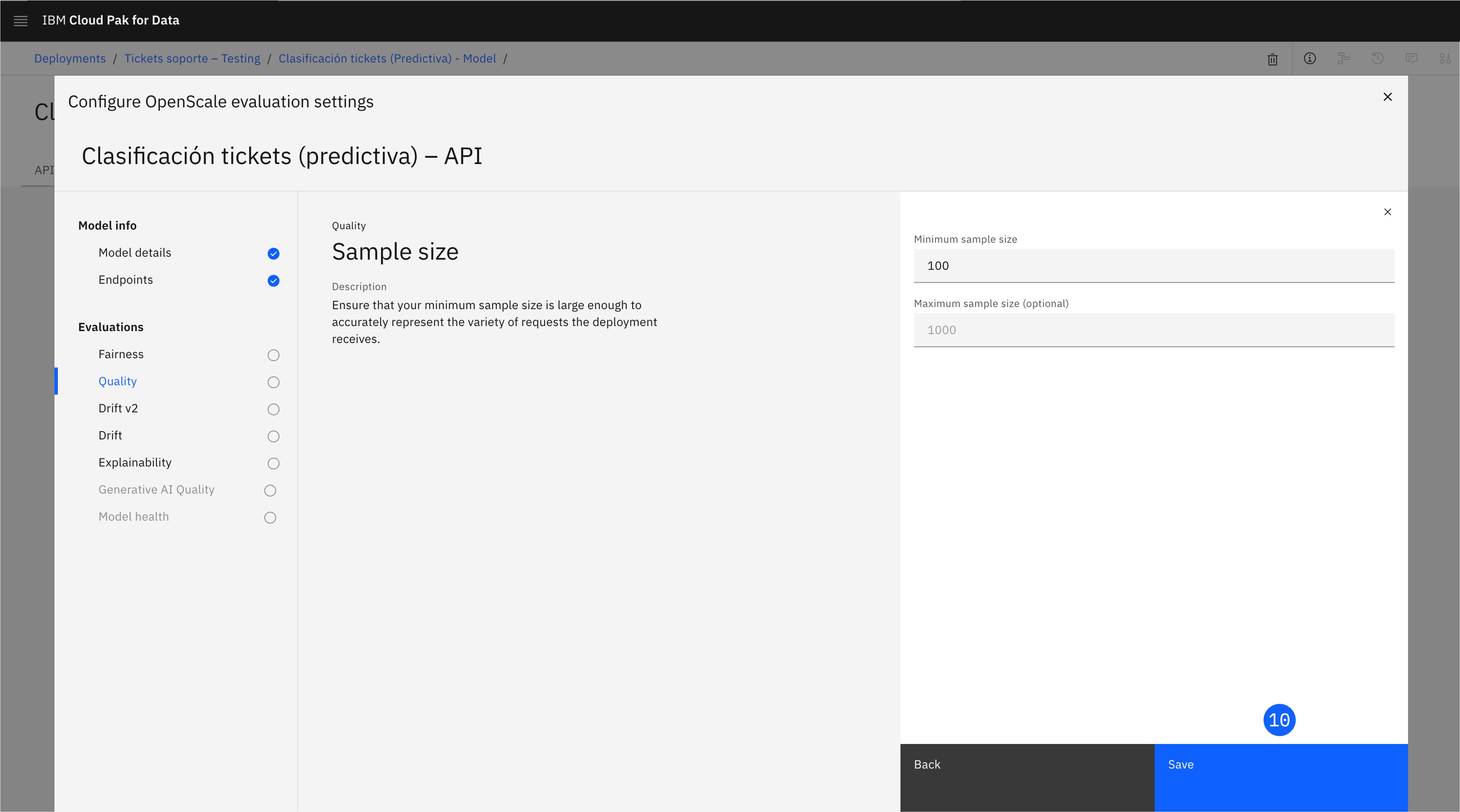

Configura el Minimum sample size a 100 y haz click en Save..

-

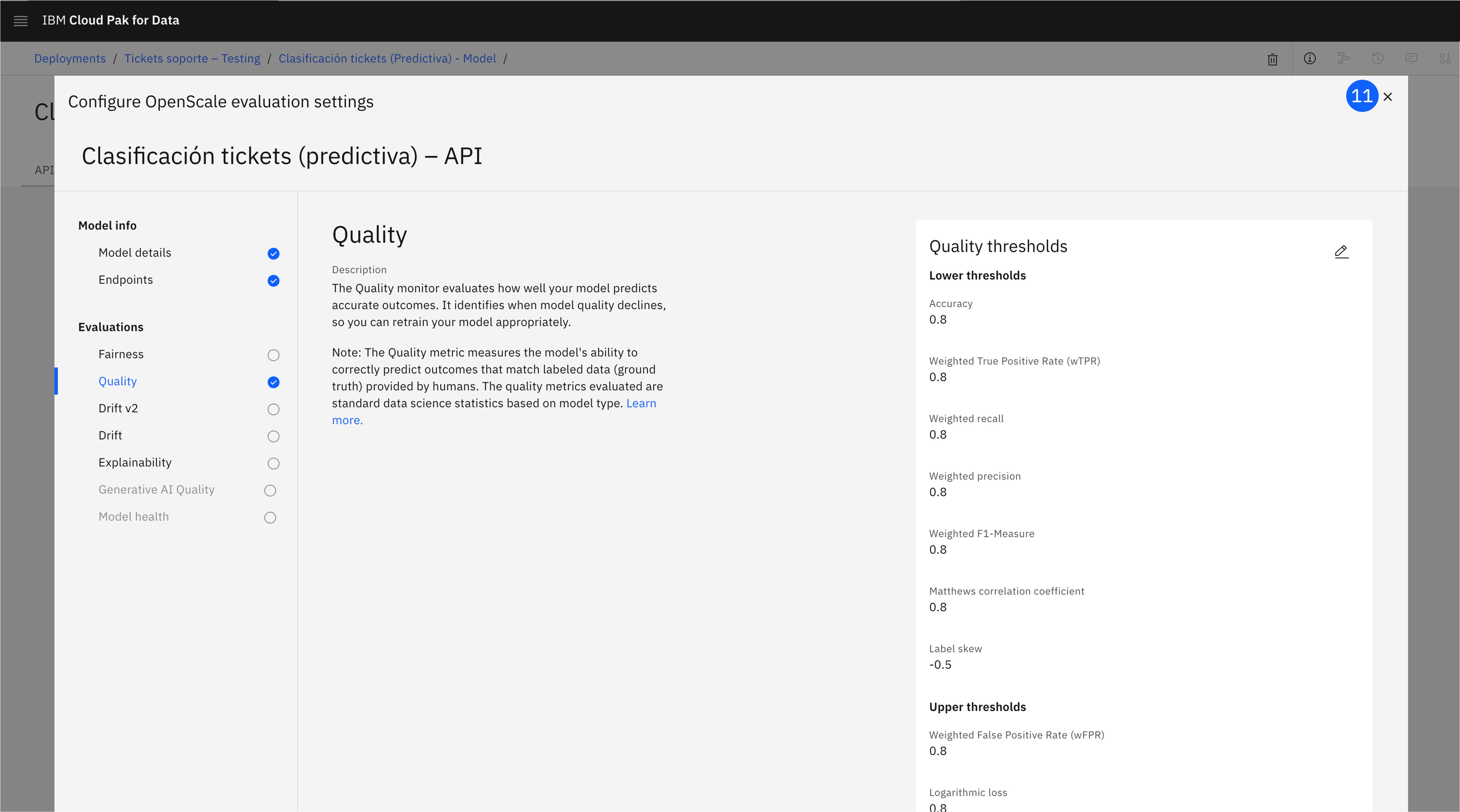

Una vez configurada la métrica, cierra esta ventana.

-

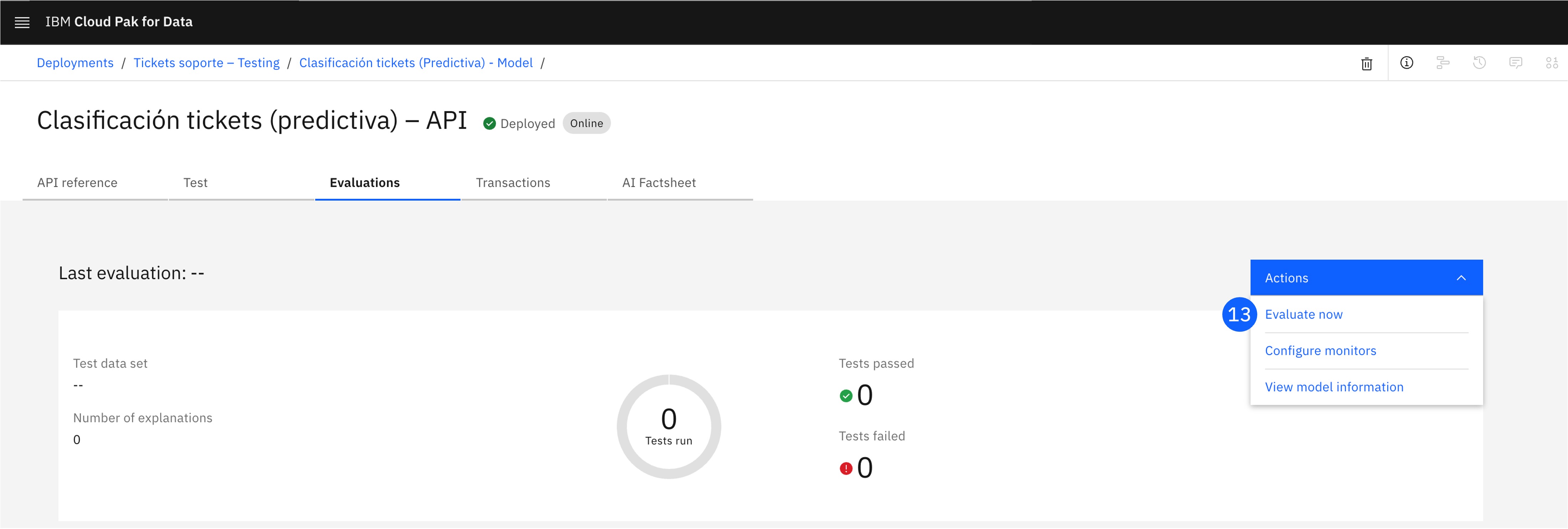

Haz click en el desplegable de Actions.

-

Pulsa Evaluate now.

-

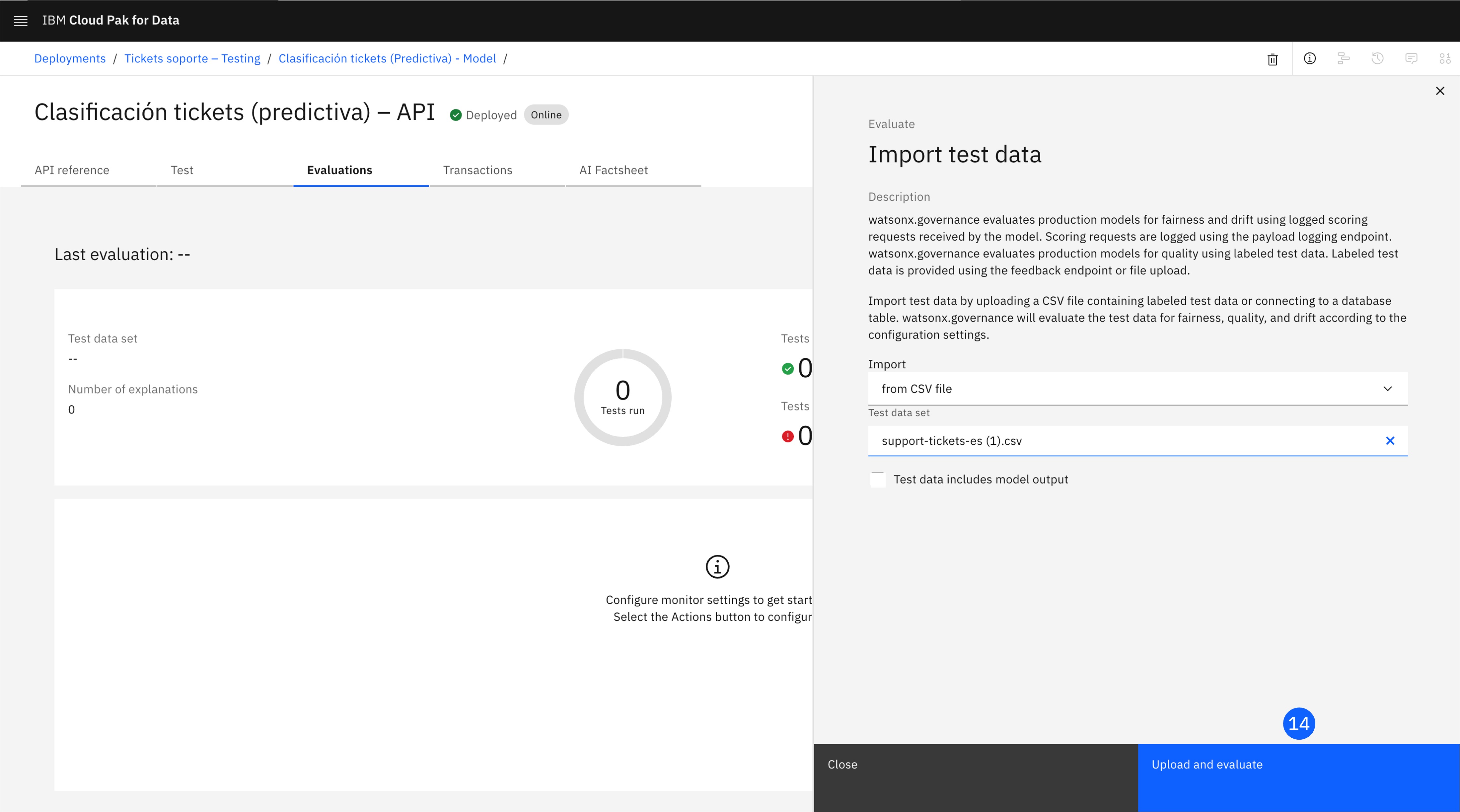

En esta ventana, selecciona from CSV en la sección Import, y arrastra el archivo support-tickets-es.csv que contiene los datos de evaluación, y pulsa Upload and evaluate. La casilla Test data includes model output NO debe estar marcada.

-

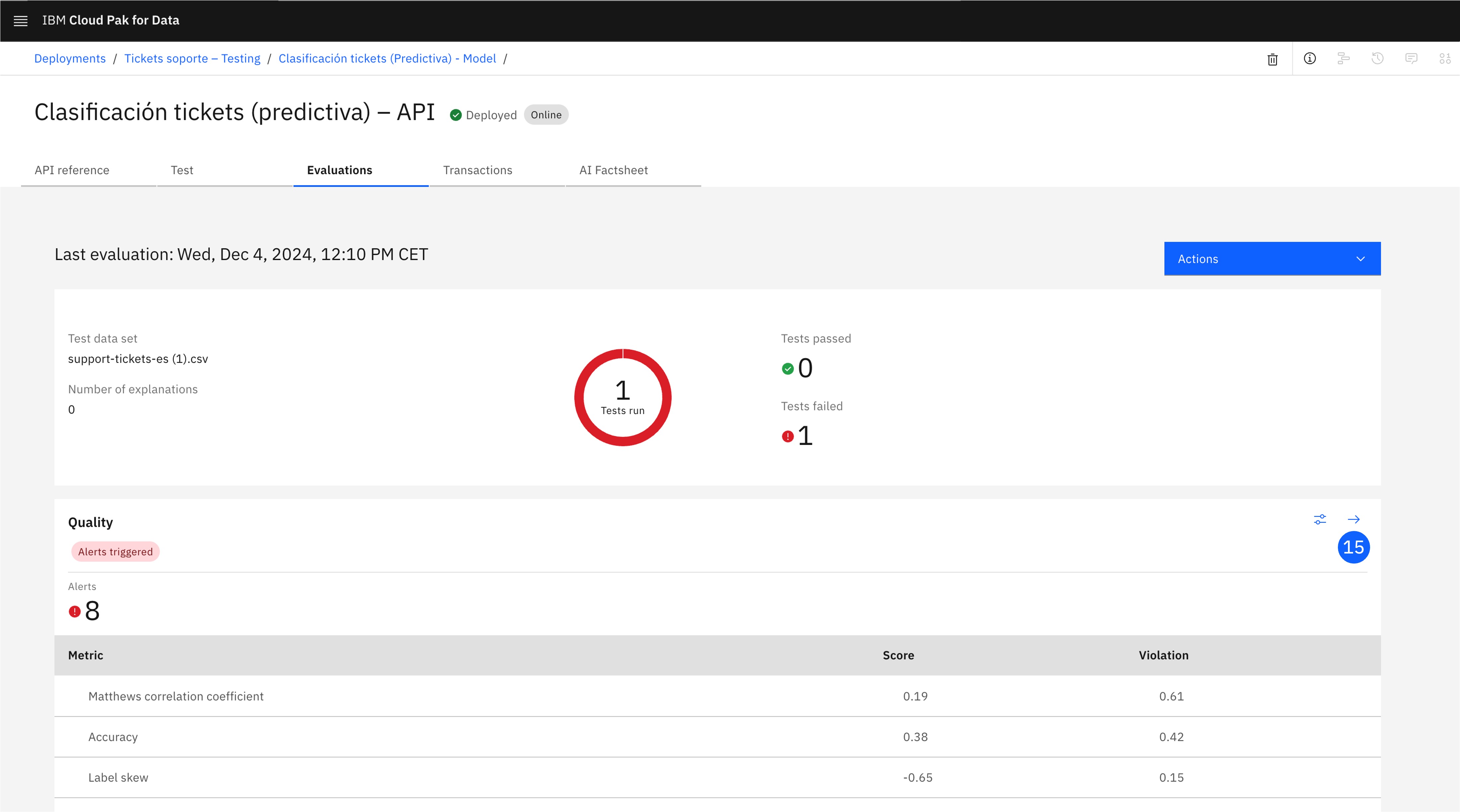

La evaluación puede llevar unos minutos. Una vez completada, explora la sección Quality, que incluye los resultados para todas las métricas con sus alertas asociadas. Pulsa el icono de la flecha, que abrirá una pantalla con más información, como una matriz de confusión y cada uno de los registros.

5. Visualiza el ciclo de vida completo

Para finalizar, visualiza el ciclo de vida completo actualizado en la AI Factsheet y AI use case.

-

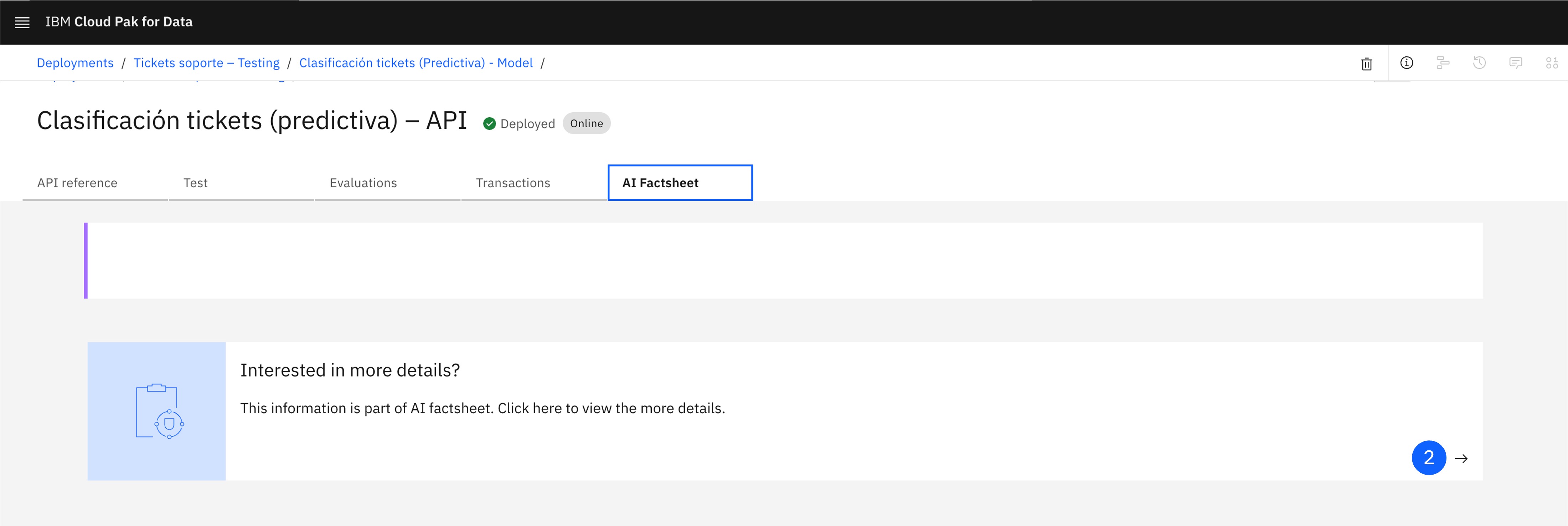

En la ventana del despliegue, abre la pestaña AI Factsheet.

-

Esta pantalla incluye exclusivamente información sobre las métricas del despliegue. Para visualizar la ficha completa, pulsa en el icono de More details.

-

También puedes volver al AI use case desde el menú desplegable lateral, y una vez abierto, explorar el ciclo de vida en la pestaña Lifecycle.

6. Tarea: Promociona a un espacio de despliegue de producción

¡Hazlo tú!

Para completar este último paso, deberás pasar el model al espacio de despliegue creado en el laboratorio anterior para ser puesto en operación y completar el ciclo de vida.

Al completar este paso, las tres fases estarán pobladas en la AI Factsheet del modelo y en el ciclo de vida del AI usecase.

7. Conclusiones

¡Enhorabuena! Has completado este laboratorio.

¿Qué hemos aprendido?

Como en el laboratorio anterior, observaste cómo la plataforma watsonx.governance ofrece una solución integral para gestionar los modelos, rastreando los metadatos y el rendimiento de los modelos en cada fase del ciclo de vida.