Monitorización y Evaluación de IA con watsonx.governance

La monitorización de los modelos de IA es un aspecto crítico de la gobernanza de los modelos, ya que permite a los equipos de desarrollo y operaciones asegurarse de que los modelos en producción siguen funcionando de acuerdo a los estándares de calidad y rendimiento establecidos.

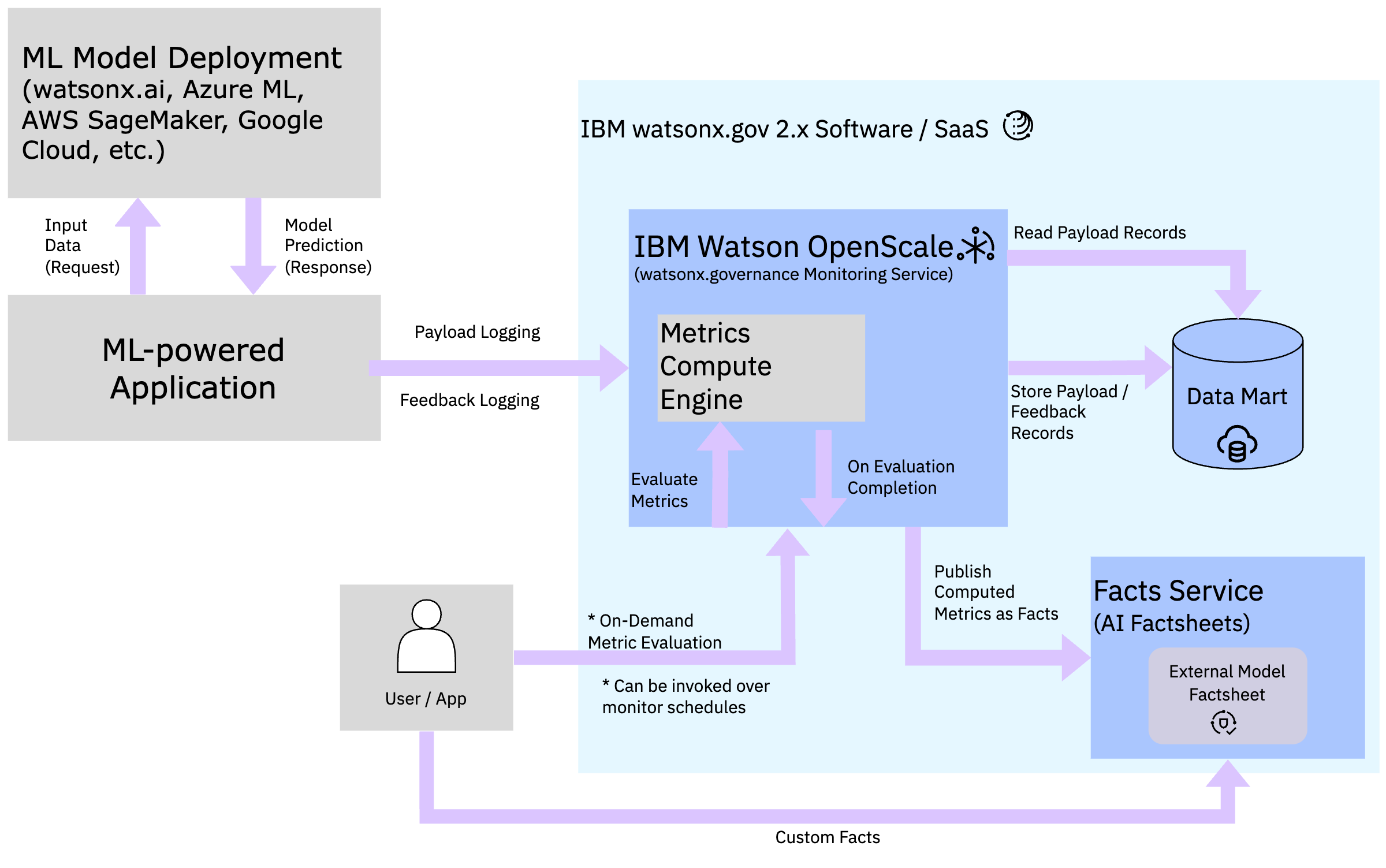

En watsonx.governance, la monitorización se basa en la captura de métricas de rendimiento y calidad de los modelos en producción, este proceso es realizado por el servicio de IBM Watson OpenScale, que permite monitorizar y gestionar despliegues de modelos de IA, desde aquellos en entornos de desarrollo hasta los despliegues en producción.

Las métricas de evaluación calculadas y registradas en OpenScale son automáticamente sincronizadas con AI factsheets para visualizar y analizar estos datos de una forma más accesible. Además, la plataforma ofrece la posibilidad de configurar alertas y notificaciones para detectar desviaciones en el rendimiento de los modelos y tomar medidas correctivas de forma proactiva.

En este módulo de formación, aprenderemos a monitorizar un modelo de IA generativa desplegado en Azure OpenAI utilizando la plataforma de watsonx.governance. Tambien aprenderemos a configurar métricas y facts personalizadas para evaluar el rendimiento de esos modelos y trazarlos de una forma que se alinea más con las necesidades de negocio de la organización.

Flujo de Monitorización y Evaluación

El flujo de monitorización de OpenScale se compone de la siguientes forma:

- Al crear un despliegue en la plataforma de IBM watsonx, se crea una subscripción en OpenScale que representa el modelo desplegado.

- Una vez configuradas las métricas y monitores de calidad, OpenScale comienza a capturar los datos de entrada y salida (payload logging) del modelo cada vez que se realiza una evaluación (en desarrollo o pre-producción), o tras cada inferencia si el modelo está en producción.

- Todos los datos de monitorización y métricas calculadas son almacenados en una base de datos conocida como datamart (generalmente una base de datos Db2 o PostgreSQL).

- Dependiendo del monitor configurado, OpenScale calcula las métricas de calidad y rendimiento del modelo periodicámente (normalmente cada hora) y las registra en el datamart.

- Nota: Si el modelo no ha registrado nuevos payloads desde la última evaluación, OpenScale no realizará el cálculo de métricas.

- Las métricas calculadas son visualizadas en la interfaz de usuario de OpenScale y sincronizadas con AI factsheets para su análisis y visualización.